Abbiamo affrontato in altri articoli il problema della tutela degli output dell’intelligenza artificiale e quello del machine learning tramite contenuti protetti e dati personali. Oggi parliamo della tutela dei fruitori di contenuti prodotti dall’IA, sotto il particolare profilo della loro riconoscibilità.

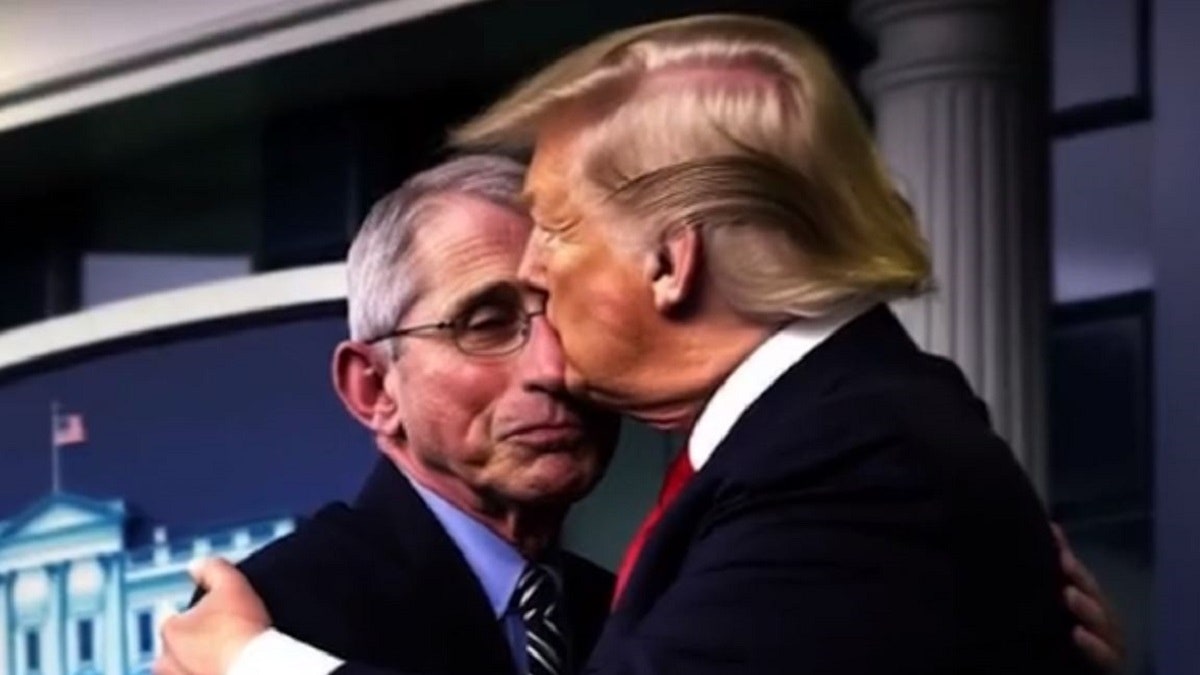

L’IA consente di manipolare immagini e video per creare contenuti tanto realistici da sembrare autentici. L’utilizzo di queste tecnologie pone anzitutto un problema di violazione dei diritti del soggetto umano eventualmente rappresentato, ma anche un tema di affidamento da parte di chi entra in contatto con il contenuto non genuino. Questo aspetto dell’IA è affrontato nei recenti provvedimenti dell’Unione europea e del governo italiano.

Il testo europeo che regola alcuni aspetti dell’IA – il c.d. AI ACT in via di emanazione – prevede all’art. 50 un’articolata disciplina in questa materia. In sintesi, questa norma chiede anzitutto ai fornitori di sistemi di IA che generano contenuti di qualunque genere (audio, immagine, video o testuali) di garantire che gli output siano marcati come generati dall’IA. Questa regola non si applica nel solo caso in cui i sistemi di IA svolgano una funzione di mera assistenza all’attività umana, senza modificare in modo sostanziale gli input forniti dall’utilizzatore (il warning non serve dunque ad esempio per un’immagine migliorata con Photoshop).

L’art. 50 obbliga dunque anzitutto gli sviluppatori a fare in modo che i contenuti generati dai loro sistemi di intelligenza artificiale siano marcati in modo da essere riconoscibili come tali a un’analisi informatica. Regole stringenti sono poi poste a carico anche di chi utilizzi sistemi di IA per generare i c.d. deep fake. Trattasi dei contenuti che l’AI ACT (art. 3(60)) definisce come “un’immagine o un contenuto audio o video generato o manipolato dall’IA che assomiglia a persone, oggetti, luoghi, entità o eventi esistenti e che appare falsamente autentico o veritiero”. Coloro che utilizzino sistemi di IA per generare “deep fake” devono rendere noto “in maniera chiara e distinguibile al più tardi al momento della prima interazione o esposizione” che il contenuto è stato generato o manipolato artificialmente. Le modalità di questa indicazione possono variare a seconda del contenuto e del contesto, considerato che qualora esso faccia parte di un’opera che ha fini “manifestamente artistici, creativi, satirici o fittizi”, gli obblighi di trasparenza si limitano alla rivelazione dell’esistenza di tali contenuti manipolati, senza “ostacolare l’esposizione o il godimento dell’opera”.

Anche il recente disegno di legge proposto dal governo italiano in tema di IA propone tra l’altro delle regole in linea con quanto previsto dall’IA Act, con particolare attenzione per i contenuti di informazione. L’art. 23 del DDL IA prevede infatti (intervenendo sulla disciplina di settore, il Testo Unico dei Servizi Media Audiovisivi) che qualunque contenuto informativo diffuso da emittenti e piattaforme (televisive o radiofoniche) che sia generato o modificato dall’IA in modo da presentare come reali fatti o informazioni che non lo sono, deve essere reso chiaramente riconoscibile dagli utenti mediante inserimento di un elemento o segno identificativo riconoscibile (ad esempio la dizione “IA”), all’inizio e fine della trasmissione, e a ogni ripresa del programma a seguito di interruzione pubblicitaria. Anche il DDL IA mostra un maggior favore per i contenuti “creativi, satirici, artistici o fittizi”, rispetto ai quali non è richiesta l’apposizione del segno di riconoscimento previsto per i programmi informativi. Il DDL IA introduce poi un obbligo a carico delle piattaforme di condivisione dei contenuti, che dovranno rendere disponibile una funzionalità che consenta agli utenti di indicare quali contenuti caricati sono eventualmente deep fake. Il DDL IA rende tuttavia illecita (art. 25 DDL IA), sanzionandola penalmente, la diffusione di deep fake che cagionino al soggetto rappresentato un danno ingiusto, introducendo nel codice penale (art. 612-quater) il reato di “Illecita diffusione di contenuti generati o alterati con sistemi di intelligenza artificiale”, punito con la reclusione da uno a cinque anni.

La legislazione europea e quella nazionale si sono dunque entrambe orientate verso un assetto che non vieta i contenuti deep fake che non provocano un danno ingiusto a una persona determinata, salvo richiedere che essi siano effettivamente riconoscibili, con misure la cui idoneità allo scopo è da valutare a seconda dei casi e dei contenuti.