Tra crisi climatica, guerre e pandemie, la sensazione è che gli abitanti del pianeta Terra – umani e non – potrebbero non avere davanti a loro un brillante futuro proiettato sul lungo termine. Nonostante questo, o forse proprio per questo, negli ultimi dieci anni circa si è sviluppata una filosofia che pone l’accento esclusivamente sulle prospettive di lungo, lunghissimo termine. Una filosofia che da Oxford si è rapidamente diffusa tra le élite tecnologiche e finanziarie della Silicon Valley: il lungotermismo, per l’appunto.

Nato come costola del ricchissimo effective altruism (una forma di filantropia utilitarista, che predica la necessità di svolgere lavori estremamente remunerativi per donare cifre immense in beneficenza), il lungotermismo si propone di garantire all’essere umano un futuro a lunghissimo termine (anche milioni di anni), al fine di prosperare e proliferare in tutta la galassia.

Questa filosofia, che come vedremo assume spesso i tratti del culto, è al centro del primo saggio della giornalista Irene Doda (che lavora anche per Wired): L’utopia dei miliardari: analisi e critica del lungotermismo (appena uscito per Edizioni Tlon). In meno di cento pagine, questo pamphlet condensa genesi, evoluzione, ripercussioni politiche e sociali e soprattutto gli aspetti più problematici e inquietanti del lungotermismo, anche con l’obiettivo di sollevare un dibattito pubblico che, fino a oggi, è spesso mancato.

Alle estreme conseguenze

Per capire come il lungotermismo giunga alle pericolose (e a volte deliranti) conclusioni che tra poco vedremo, bisogna prima fare un passo indietro e vedere in che modo, partendo da premesse condivisibili, questa filosofia riesca a spingersi oltre il limite del razionale e dell’accettabile.

Molti di noi potrebbero per esempio ritenere ragionevole il sacrificio di due persone oggi al fine di salvarne dieci, cento o mille domani. Un discorso simile, spostando l’accento temporale dai giorni alle generazioni, vale per la giustizia intergenerazionale: chi negherebbe che le passate generazioni avrebbero dovuto sacrificare una parte di benessere materiale, e limitare lo sfruttamento del pianeta, al fine di salvaguardarlo per le prossime generazioni (e per gli abitanti non umani della Terra)?

Che cosa succede, però, se portiamo queste condivisibili conclusioni alle loro estreme conseguenze logiche? Un esempio di ciò che può avvenire viene citato proprio da Irene Doda in L’utopia dei miliardari: “Immaginiamo una situazione ipotetica in cui un soggetto, vivo nel tempo presente, abbia i mezzi, la tecnologia e la volontà di salvare dalla povertà un miliardo di persone. Allo stesso tempo ha anche un’altra opzione: compiere un’azione che benefici una frazione infinitesimale degli esseri umani che potrebbero esistere qualora colonizzassimo il Superammasso della Vergine, il cluster galattico che contiene la Via Lattea. Quale sarebbe la scelta più etica per i lungotermisti?”.

A questo punto, è necessario fare due calcoli, per i quali Irene Doda si rifà al filosofo “lungotermista pentito” Émile P. Torres: “Basta fare due conti: lo 0,000000001 per cento di 10^23 persone è pari a dieci miliardi di persone. Ciò significa che, se si vuole fare del bene, bisogna concentrarsi su queste persone del futuro piuttosto che aiutare chi oggi è in estrema povertà”.

È solo questione di numeri

È esclusivamente una questione numerica: partendo dal presupposto lungotermista che le vite del futuro hanno lo stesso valore di quelle odierne, è meglio salvare dieci miliardi di persone lontanissime nel tempo che salvarne un miliardo di esistenti.

Non è difficile intuire quanto sia assurdo dare la priorità a decine di miliardi di ipotetiche vite future rispetto a un qualunque numero di vite esistenti adesso. A tenere in piedi il ragionamento lungotermista è esclusivamente la fredda logica matematica: un aspetto che dimostra inoltre come logica e razionalità, a un certo punto, si scollino e non procedano più di pari passo.

Peggio ancora: questa attenzione rivolta esclusivamente al futuro permette ai lungotermisti di derubricare a questioni secondarie tutte le faccende del presente, comprese crisi climatica, diseguaglianze crescenti, fame nel mondo, guerre e pandemie. È forse proprio per questa ragione che il lungotermismo sta avendo grande successo tra i tecnomiliardari della Silicon Valley: “Si tratta in realtà di un eccellente specchietto per le allodole – scrive sempre Irene Doda -. Permette infatti a coloro che già detengono le redini del potere di non metterne in discussione i fondamenti, anzi di incrementare la loro influenza con la scusa del ‘bene dell’umanità futura’”.

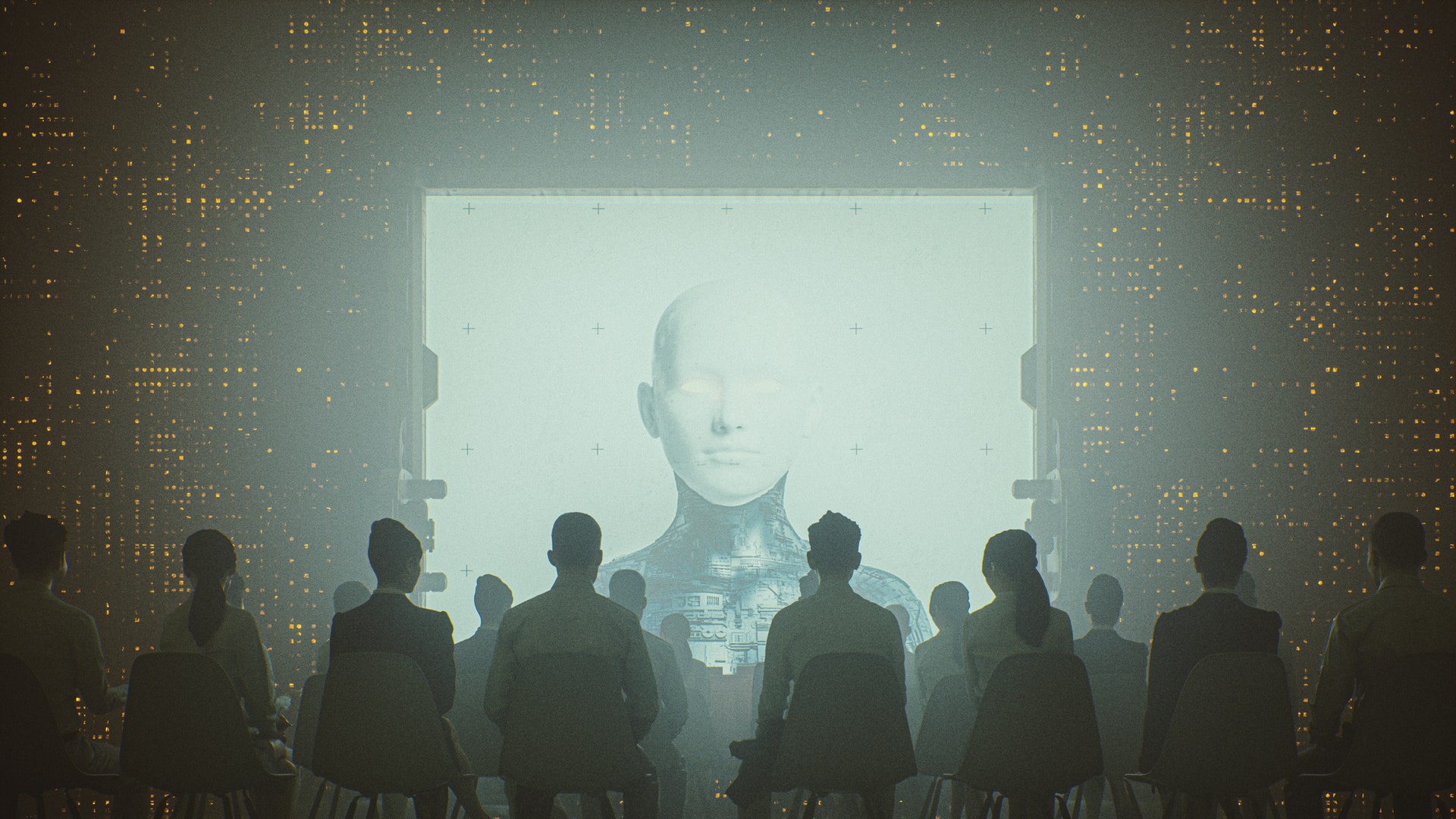

Il lungotermismo diventa insomma lo strumento perfetto per giustificare lo status quo e non impegnarsi a cambiare il presente, sminuendo l’importanza di tutto ciò che non rappresenta un rischio esistenziale. Se il termine “rischio esistenziale” vi suona familiare non è solo perché viene spesso impiegato dal fondatore di OpenAI Sam Altman o da Elon Musk (entrambi vicini al lungotermismo), ma anche perché è una delle basi teoriche del filosofo Nick Bostrom (noto per la teoria della simulazione e dei potenziali pericoli connessi all’avvento della superintelligenza artificiale), punto di riferimento indiscusso del lungotermismo.

Come abbiamo visto, l’attenzione rivolta esclusivamente ai rischi esistenziali che – per quanto remoti nel tempo e improbabili – potrebbero minacciare la sopravvivenza della specie umana fa sì che i lungotermisti reputino più importante la colonizzazione dell’universo rispetto alla crisi climatica, o che dirottino la marea di risorse economiche a loro disposizione (46 miliardi di dollari, raccolti tramite i loro think tank ed enti benefici) dalla lotta alla fame del mondo al contrasto di un’ipotetica minacciosa superintelligenza artificiale.

D’altra parte, come scrive Irene Doda, “se prendiamo la cornice del futuro lontanissimo, quasi nulla di quello che succede nel presente conta. Che importerebbe se, nello sforzo di colonizzare lo Spazio, si scatenasse una guerra letale per miliardi di persone?”. È in questa visione apocalittica, messianica, che si perde di vista un elemento di fondamentale importanza: se vogliamo cambiare il futuro, “dobbiamo farlo trasformando in primis il presente: cambiando le carte in tavola a partire dal nostro stesso sguardo. Possiamo essere tentati di fronte alle sfide attuali, non solo politiche ma anche intime e personali, di aggrapparci a ideologie salvifiche o parareligiose. Ma queste non sono che una facciata di comodo perché nulla cambi davvero”.

C’è da avere paura?

Dobbiamo davvero preoccuparci dell’impatto di una scuola di pensiero dai tratti evidentemente deliranti? La risposta è positiva, non solo per la quantità enorme di soldi in dotazione alle realtà collegate al lungotermismo, e non solo per il potere economico e mediatico di molti adepti (ai già citati Altman e Musk possiamo aggiungere il creatore di Ethereum Vitalik Buterin, il fondatore di Anthropic Dario Amodei e molti altri), ma anche perché queste teorie stanno da qualche tempo facendosi largo all’interno delle più importanti istituzioni del mondo.

“Toby Ord (uno dei principali teorici, assieme a William MacAskill) è stato consigliere dell’Organizzazione Mondiale della Sanità, della Banca Mondiale, del World Economic Forum, del Consiglio per l’Intelligence degli Stati Uniti e del Governo britannico”, scrive Irene Doda. “Ha recentemente contribuito a scrivere un documento del Segretario generale delle Nazioni Unite, intitolato ‘La nostra comune agenda’, che menziona direttamente il lungotermismo, oltre a utilizzare termini come ‘rischi esistenziali’”.

Le conseguenze sul mondo reale che questa teoria può concretamente avere non vanno quindi sottovalutate. Come non va confusa l’essenza di questa teoria, che dietro una patina tecnologica, razionale e scientifica si dimostra invece estremamente antropocentrica (l’essere umano è addirittura l’unica che cosa che conta in tutto l’universo). I presupposti da cui muove il lungotermismo non sono soltanto conservatori e antiquati, ma sono gli stessi che ci hanno condotto dove ci troviamo oggi.

“Gli esseri umani sono una specie transitoria in un enorme mistero cosmico – scrive Doda nelle ultime pagine del saggio -. Proprio per questo non vale la pena fare scorrere fiumi di sangue, uccidersi a vicenda per il potere. Proprio perché non siamo che una minuscola parte di un gioco che fatichiamo a comprendere, persino a concepire, dobbiamo lavorare per un raggiungimento di condizioni migliori sul pianeta. È un punto di vista differente rispetto a quello lungotermista, che invece ha la pretesa non solo di conoscere ma anche di dominare e colonizzare parte dell’Universo conosciuto. La prospettiva dei lungotermisti rispetto al cosmo può definirsi imperialista”.