La creazione di contenuti, da sempre espressione della creatività umana, si trova a un bivio epocale con l’avvento dell’intelligenza artificiale (AI) generativa. Nuove possibilità si aprono, ma con esse sorgono interrogativi profondi sul ruolo dell’uomo nel processo creativo e sulla distinzione tra realtà e artificio. In questo contesto, la regolamentazione assume un ruolo cruciale per affrontare i rischi etici e morali connessi a questa tecnologia emergente. L’Unione europea e il

governo italiano hanno già avviato iniziative in questo senso. La coalizione internazionale C2PA, per esempio, propone un protocollo per tracciare i contenuti generati artificialmente, basandosi su un sistema di “filigrana” invisibile e meta-tag identificativi.

In C2PA sono presenti numerose organizzazioni appartenenti al settore della generazione artificiale di contenuti, come per esempio Microsoft, Google e OpenAI, rendendola la più grande coalizione operante nel settore della generazione artificiale. L’iniziativa impone alle organizzazioni produttrici di “auto certificare” la provenienza di un contenuto (per esempio, una immagine) inserendo una “filigrana” invisibile a occhio umano e una serie di “meta tag” (ovvero di informazioni) correlati che ne identifichino la provenienza includendo: data di produzione, firma del produttore, geolocalizzazione della produzione e certificato di originalità.

Sebbene lodevole per l’intento, l’iniziativa presenta alcune note criticità che è giusto ricordare. La prima è la difficoltà di adozione globale: l’efficacia di tale protocollo di intesa dipende dalla collaborazione di tutti i produttori di AI generativa, un obiettivo arduo in un contesto geopolitico frammentato ove risulta difficile accordarsi su tematiche ben più consolidate, come per esempio diritti dei lavoratori, sanità, programmi scolastici e persino sui confini geografici. La seconda è la mancanza di un controllo indipendente: l’autocertificazione da parte dei produttori, senza un ente terzo di verifica, rischia di essere autoreferenziale e poco affidabile. Di fatto numerose sono le certificazioni internazionali che suggeriscono di evitare o ridurre al massimo i conflitti di interesse tra chi controlla e chi produce. Gli esempi sono innumerevoli dalla catena alimentare, alla filiera farmaceutica fino al comportamento sul luogo di lavoro. Perché nel settore dell’origine del dato non deve essere uguale ? Inoltre quale sarà l’ente di controllo ? Ci fideremo tutti di un ente unico oppure ogni paese ne creerà uno proprio?

La terza criticità concerne la vulnerabilità alla manomissione: la filigrana può essere rimossa

utilizzando, paradossalmente, tecniche di intelligenza artificiale. Tale sistema di verifica infatti è inaffidabile contro avversari motivati capaci a rimuovere o alterare la filigrana. Agli occhi umani essa non è percettibile ma a occhi “artificiali” essa è facilmente riconoscibile in quanto presenta un “rumore” o una “anomalia” percettibile da occhi artificiali. Essa può tuttavia essere rimossa attraverso un sistema di miglioramento della qualità dell’immagine (o del suono). Tecnicamente

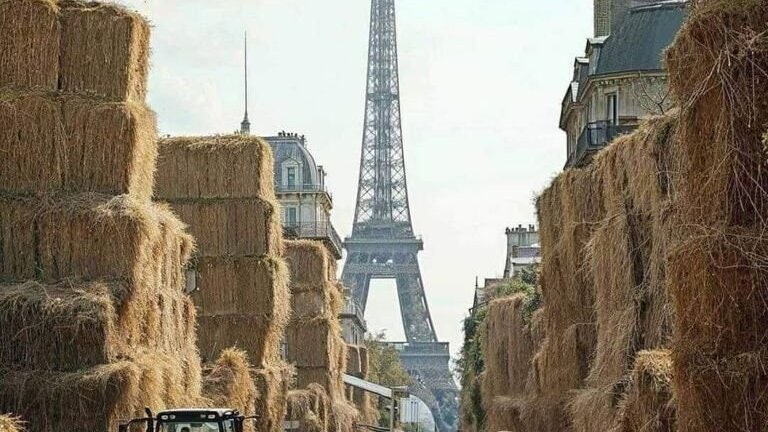

si introduce un rumore nel contenuto (un suono bianco oppure delle sgranature all’interno del contenuto visivo) per poi essere rimosso attraverso sistemi di miglioramento-immagine. Il risultato è una immagine migliorata rispetto all’originale e senza filigrana. Contrariamente la filigrana può essere inserita in ogni momento. Ovvero prendere una immagine non generata da intelligenza artificiale e inserire informazioni al suo interno come se fosse stata realizzata da un generatore artificiale per il quale è stato creato un certificato.

Le immagini, così come i filmati o suoni, sono ampiamente utilizzate nel contesto quotidiano. Dalle assicurazioni che acquisiscono immagini per verificare l’entità un sinistro, ai giornali che fanno di queste ultime un vero e proprio asset, per finire in ambienti governativi ove un immagine o un suono possono essere utilizzate per azioni politiche o per motivi propagandistici. Il problema da affrontare è pertanto talmente vasto che non credo che un unico strumento/regolamentazione possa essere considerato come “risolutivo”. Per questo motivo diverse soluzioni dovranno unirsi per affrontare il problema da differenti punti di vista. Genericamente parlando è evidente che il protocollo proposto da C2PA non sia stato pensato per affrontare un possibile “avversario” ma piuttosto per affrontare tematiche relative all’errore o al fraintendimento. Ovviamente un avversario che volesse avviare attività di propaganda oppure operazioni ingannevoli, va da sé che non utilizzerà strumenti con filigrana per essere tracciato. Una possibile soluzione potrebbe essere quello di unificare l’approccio di C2PA, ovvero della auto-certificazione attraverso filigrana, con l’approccio di terze parti che utilizzano sistemi di AI per individuare l’origine del contenuto anche ove la filigrana non fosse presente. Questo risultato si potrebbe ottenere attraverso l’inserimento di un “tag” (o di un campo) nello standard C2PA, basato su sistemi di intelligenza

artificiale addestrati per l’identificazione di contenuti artificiali, fornirebbe un elemento probabilistico di verifica all’utente anche in caso di mancanza di auto certificazione. Qualcosa di questo tipo stiamo sviluppando con il progetto IdentifAI.net , sebbene in versione beta, che sfrutta un modello di intelligenza artificiale capace di individuare la provenienza del contenuto con una certa probabilità mentre per le immagini con auto-certificazione sono presenti le informazioni inserite in C2PA.